Vermutlich wird im Rückblick das Jahr 2022 das Jahr der Künstliche-Intelligenz-verändert-unser-Leben-Essays sein. Und es gibt ein paar Standardformate für diese Essays – das eine ist der komplett von ChatGPT geschriebene Text, das andere die große Technikkritik samt Raunen darüber, was menschliche Kreativität nun wirklich ausmacht, das dritte der Hype-Artikel darüber, dass sich jetzt wirklich alles ändert.

Und ja, ChatGPT und die ganzen anderen generativen Modelle – die Bilderzeugung mit Stable Diffusion, Midjourney oder Dall‑E; die Übersetzung mit DeepL – all das fühlt sich schon sehr nach Zukunft an. Als 2007 das iPhone auf den Markt kam, war nicht so ganz klar, dass es den Mobilgerätemarkt komplett umkrempeln würde, das unter einem Smartphone nicht ein Tastentelefon mit Bildschirm zu verstehen ist, sondern ein universell nutzbarer Computer in einem Softwaregarten, der zur Not auch ein Telefon sein kann. Im nachhinein betrachtet hat das iPhone massiv etwas verändert. Unser Zugang zur Welt ist ein kleiner schwarzer Bildschirm in der Hosentasche oder Handtasche, egal ob mit iOS oder Android als Betriebssystem. Das ist das Gerät, mit dem wir im Internet unterwegs sind, Fahrkarten kaufen, uns orientieren, die Uhrzeit ablesen, Fitnesswerte speichern und natürlich ständig und überall Fotos und Videos machen.

Für mich fühlt ChatGPT sich ein bisschen so an, als ob damit ein ähnlicher Umbruch verbunden sein könnte. Vielleicht liegt dieses Gefühl auch daran, dass ich mit Siri und Alexa (und erst recht nicht mit Cortana) nie warm geworden bin; was hier noch als OpenAI-Feldversuch und wissenschaftliches Experiment läuft, und noch ziemlich fehleranfällig und gerade stark überlastet ist, könnte unseren Alltag doch ganz erheblich verändern.

Und das schreibe ich, obwohl ich weiß, dass ChatGPT (und OpenAI als Firma dahinter, und auf maschinellem Lernen basierende Sprachmodelle) mit erheblichen Problemen verbunden sind. Das eine sind die einem solchen Modell inhärenten Beschränkungen, dazu unten mehr. Das andere ist schlicht die Tatsache, dass die gigantischen Trainigsdatensätze für generative AI auch mit einem gigantischen Stromverbrauch verbunden sind, und dass allen Anstrengungen zum Trotz diese Datensätze erhebliche ethische Fragen aufwerfen. Das reicht von Urheberrechtsdebatten – was passiert, wenn eine bildgenerierende AI sich an vorhandenen Bildern orientiert, und die Ähnlichkeit in der Rekombination allzu deutlich wird – bis hin zum erheblichen Problem des Bias in den Daten. Eine AI, die aufgrund der im Internet der letzten fünf Jahre verfügbaren Texte Sprechen gelernt hat, wird – gelinde gesagt – ein seltsames Weltbild haben und das auch reproduzieren.

Trotz dieses Wissens bin ich von dem, was ChatGPT kann, positiv überrascht.

ChatGPT: ein Sprachspielgenerator

Und zumindest im Feldversuchsinterface wird sehr deutlich darauf hingewiesen, dass manche Antworten gefährlich sein können, dass ein Sprachmodell nicht über echtes Wissen verfügt, und dass es durchaus auch vorkommen kann, dass Antworten falsch sind. Was ChatGPT kann: Texte generieren und natürlichsprachliche Fragen beantworten. Dabei kommt das Sprachmodell nicht nur mit Englisch klar – das dürfte den größten Teil des Trainigsdatensatzes ausmachen – sondern kann beispielsweise auch ganz passabel auf Deutsch kommunizieren. Ich vermute, dass das für die meisten im Netz verbreiteten Sprachen gilt. Und ebenso „beherrscht“ ChatGPT eine ganze Reihe von Programmiersprachen.

Es liegt nahe, eine Maschine wie ChatGPT zu vermenschlichen. Letztlich passiert hier aber nichts anderes, als das in einer sehr großen Textmenge nach Mustern gesucht und in dem dadurch aufgespannten Raum nahe Punkte miteinander verbunden werden. Was dabei herauskommt, klingt so, als würde ChatGPT einen verstehen – aber das konnte in ganz begrenzter Weise auch schon ELIZA.

Dass ChatGPT nicht über Weltwissen verfügt, sondern über Verknüpfungen in einem Datenraum rechnet, führt manchmal zu seltsamen Fehlschlüssen. Dieses Modell kann nicht wirklich rechnen (genauso, wie eine der größten Herausforderungen für Stable Diffusion etc. darin besteht, Hände mit fünf – und nicht mit drei oder sechs – Fingern zu generieren). Und manchmal werden naheliegende Fakten vertauscht. Oder Schlussfolgerungen gezogen, die in gewisser Weise kluge Fehler sind – wie sie, Achtung, da vermenschliche ich dann doch schon wieder – auch Kinder in ihrer Entwicklung machen.

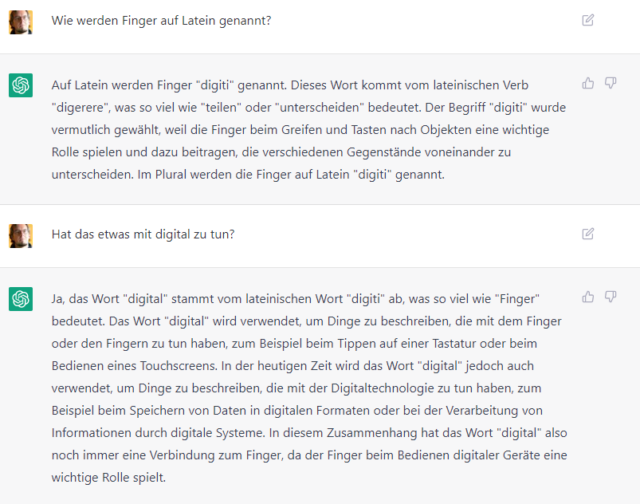

Die erste Antwort – auf die Frage, wie „Finger“ auf Latein genannt werden – stimmt so halbwegs. „Digiti“ ist tatsächlich der lateinische Begriff dafür, ob die Herleitung von „digirere“ so stimmt, kann ich nicht beurteilen.

Interessant wird es bei der zweiten Frage: wie hängen „digitus“ und „digital“ miteinander zusammen? Und da reimt sich ChatGPT dann einen erheblichen Blödsinn zusammen und behauptet, dass wir von „digital“ sprechen, weil Tastaturen und Touchscreens mit dem Finger bedient werden. In Wirklichkeit geht es dabei darum, dass es um (an den Fingern) abzählbare konkrete und unterscheidbare Zahlen geht.

Trotzdem klingt das, was ChatGPT da fabuliert, plausibel. Relativ wortreich und klug klingend wird also etwas behauptet, was so nicht stimmt – manche haben ChatGPT deswegen auch als „bullshit machine“ oder als „digitalen mansplainer“ bezeichnet. Das geht bis hin zur Erfindung von Referenzen – die aussehen wie echte wissenschaftliche Arbeiten und Zitatnachweise, aber schlicht nicht existieren. Immerhin: die Form wurde beachtet.

Ein zweites Beispiel: Die Erfindung der im Meer lebenden Familie der Dornhai-Ameisenigel. Achtung – da steckt sehr viel Unsinn drin!

Etwas freundlicher ließe sich von träumenden Maschinen sprechen. Nicht umsonst heißt eines der ersten Bildverarbeitungsnetzwerke DeepDream – und auch die Ergebnisse der neusten Bildgenerierungssysteme wirken manchmal noch so, als ob da Träume mitgeschnitten würden. Da, wo ChatGPT nicht an Fakten gebunden ist, kommen dann tatsächlich erstaunliche Ergebnisse heraus (wie hier auf den Prompt: „Tell me a story about space pirates.“ hin).

Nebenbei: das ganze ist ja probabilistisch – insofern führt jeder neue Versuch unter diesem Prompt auch zu einer neuen Geschichte. Gleichzeitig lassen sich Muster erkennen, die immer wieder auftauchen. Etwas unfreundlicher gesagt: Klischees, auch literarische Klischees, die munter reproduziert werden.

Träumende Maschinen – schauen wir uns das mal an

Aber fragen wir ChatGPT selbst.

TW: Von was träumt ein Sprachmodell?

ChatGPT: Ein Sprachmodell ist kein lebendes Wesen und deshalb kann es nicht träumen. Sprachmodelle sind computergestützte Systeme, die darauf ausgelegt sind, natürliche Sprache zu verarbeiten und zu verstehen. Sie sind nicht in der Lage, Gedanken oder Träume zu haben. Stattdessen konzentrieren sie sich auf die Aufgabe, die ihnen von den Programmierern gegeben wurde, wie zum Beispiel das Beantworten von Fragen oder das Übersetzen von Texten.

TW: Und von was träumen Androiden?

ChatGPT: Androide sind künstliche Intelligenzen, die in der fiktionalen Welt oft menschenähnlich dargestellt werden. In der realen Welt gibt es zwar auch künstliche Intelligenzen, die menschenähnlich aussehen, jedoch sind diese nicht in der Lage, Gedanken oder Träume zu haben, da sie nicht wie lebende Wesen funktionieren. Androide sind lediglich Programme, die auf bestimmte Aufgaben trainiert wurden und sich auf diese konzentrieren, ohne die Fähigkeit zu haben, Gedanken oder Träume zu produzieren.

TW: Was sagt Philip K. Dick dazu?

ChatGPT: Ich bin leider nicht in der Lage, Aussagen von Philip K. Dick zu recherchieren, da ich nur über begrenztes Wissen verfüge und keinen Zugang zu weiteren Informationen habe. Philip K. Dick war ein Science-Fiction-Autor, der viele Werke über künstliche Intelligenzen und Androide geschrieben hat. Ob er speziell zum Thema Träume von künstlichen Intelligenzen oder Androiden geschrieben hat, kann ich leider nicht sagen.

TW: Welche Bücher hat er geschrieben?

ChatGPT: Philip K. Dick war ein sehr produktiver Autor und hat viele Bücher veröffentlicht. Einige seiner bekanntesten Werke sind „Do Androids Dream of Electric Sheep?“, „The Man in the High Castle“, „Ubik“, „A Scanner Darkly“ und „VALIS“. Er hat auch zahlreiche Kurzgeschichten und Artikel geschrieben. Seine Werke sind bekannt für ihre futuristischen Themen und ihre Erkundung von Themen wie künstliche Intelligenzen, Androide, Identität und Realität.

TW: Und, träumen Androiden von elektrischen Schafen?

ChatGPT: In Philip K. Dick’s Roman „Do Androids Dream of Electric Sheep?“ wird die Frage gestellt, ob Androiden träumen können. In dem Buch sind Androiden künstliche Intelligenzen, die menschenähnlich sind und oft für illegale Zwecke missbraucht werden. Die Frage, ob sie träumen können, wird im Buch nicht direkt beantwortet und bleibt ein Mysterium. In der realen Welt gibt es keine Androiden, die träumen können, da sie nicht wie lebende Wesen funktionieren und nicht über die Fähigkeit verfügen, Gedanken oder Träume zu produzieren.

TW: Was sind elektrische Schafe eigentlich?

ChatGPT: In Philip K. Dick’s Roman „Do Androids Dream of Electric Sheep?“ sind elektrische Schafe künstliche Tiere, die von Menschen gehalten werden, um die Auswirkungen einer Katastrophe auf die Tierwelt auszugleichen. In der fiktionalen Welt des Buches haben viele Menschen elektrische Schafe statt echter Schafe, da die meisten echten Schafe aufgrund der Katastrophe ausgestorben sind. Elektrische Schafe sind also künstliche Tiere, die wie echte Schafe aussehen und sich auch so verhalten, aber nicht echt sind. In der realen Welt gibt es keine elektrischen Schafe.

TW: Halten Menschen in der echten Welt oft Schafe?

ChatGPT: In der realen Welt halten viele Menschen Schafe als Nutztiere. Schafe werden oft gehalten, um Wolle, Fleisch und Milch zu produzieren. Sie sind auch als Haustiere beliebt, vor allem auf Bauernhöfen und in ländlichen Gebieten. Die Zahl der Schafe, die von Menschen gehalten werden, variiert jedoch je nach Region und Land. In manchen Teilen der Welt sind Schafe seltener als in anderen. In der fiktionalen Welt von Philip K. Dick’s Roman „Do Androids Dream of Electric Sheep?“ sind die meisten echten Schafe aufgrund einer Katastrophe ausgestorben, weshalb viele Menschen stattdessen elektrische Schafe halten.

Drei Beobachtungen zu diesem kurzen Austausch (der zehn oder zwanzig Minuten in Anspruch genommen hat, weil ChatGPT teilweise recht lange für Antworten brauchte und häufiger Fehlermeldungen produzierte, die erst in zweitem oder dritten Anlauf behoben werden konnten).

Erstens: Was ich wirklich erstaunlich finde, ist die ziemlich gute Treffsicherheit bei indirekten Referenzen – „er“, „dazu“ etc. werden korrekt auf die vorherigen Fragen und Antworten bezogen. Und der Titel „Do Androids Dream of Electric Sheep?“ wird auch in der deutschen Übersetzung erkannt. Zudem führt ChatGPT die vorher besprochenen Themen mit – es geht hier um KI und Androiden, deswegen tauchen diese auch in der Antwort auf die Frage nach den Werken von Dick auf. Und bei der letzten Frage nach Schafen in der realen Welt wird auch noch einmal eine Aussage zu Dick getroffen.

Das Mitführen der Referenzen und der vorherigen Texte führt allerdings auch dazu, dass ChatGPT im Lauf eines Gesprächs zunehmend länger braucht und irgendwann keine Antworten mehr kommen. Da scheint irgendwas exponentiell komplizierter zu werden.

Zweitens: Zumindest ChatGPT ist so programmiert, dass es sehr zurückhaltend wird, wenn diesem System (oder hier allgemeiner: Sprachmodellen) menschliche Eigenschaften zugeschrieben werden. Die erste Antwort ist typisch für eine Antwort, in der ChatGPT auf seine Begrenzungen hinweist. Auch wird sehr klar zwischen Aussagen über fiktionale Welten und über die reale Welt unterschieden. Soweit ich das beurteilen kann, stimmen die Aussagen über Dicks Roman. Die Aussagen zur realen Welt werden meist unter Vorbehalt formuliert, siehe letzte Antwort zur Schafhaltung – „viele“, „oft“, „in manchen Teilen der Welt“ usw. Das führt zu einer gewissen Schwammigkeit; ChatGPT legt sich selten wirklich fest. Und wenn, dann passieren manchmal subtile Fehler.

Drittens: Die Antworten sind alle etwas gleich lang und haben einen ähnlichen Aufbau. Manche Phrasen wiederholen sich in längeren Austauschen. ChatGPT beherrscht unterschiedliche Sprachmuster (z.B. Tweets, englischsprachige Gedichte, erzählte Geschichten, Faktenwissen); innerhalb dieser Formen bleibt es aber recht monoton. Mit der Zeit erinnert das an Fahrstuhlmusik (andere sprechen von mediokren Hausarbeiten).

Maschinenträume: Wozu das Ganze?

Ich habe eingangs davon gesprochen, dass ich das Gefühl habe, das mit ChatGPT und ähnlichen Modellen ein technologischer Umbruch verbunden sein könnte.

Insbesondere kann ich mir vorstellen, dass Sprachmodelle – wie das mit bildgenerierenden Verfahren heute schon der Fall ist – recht bald in die Toolleiste von Textverarbeitungsprogrammen Einzug halten werden. Einem ChatGPT ein paar Fakten hinzuwerfen, um einen langweiligen Absatz zu formulieren, oder eine Zusammenfassung zu entwerfen, oder einen Text etwas zu verschönern, ihn zu übersetzen oder in einen anderes Register zu bringen – das kann ich mir sehr gut vorstellen.

Das würde dann einen Teil der kreativen Berufe deutlich verändern – Routinetexte wie der gerne als Beispiel genommene Bericht über das Fußballspiel der Lokalmannschaft lassen sich automatisch erstellen. Zugleich verändert sich die Vorstellung dessen, was Kreativität ist – Fotos machen kann heute jede*r, aber gute Fotos brauchen trotzdem handwerkliches Können und eine gestalterische Idee. Da könnte sich in den nächsten Jahren etwas verschieben. Bis hin zu der Vorstellung, dass reine Unterhaltung ohne größeren Anspruch – Modell Heftchenromane – auf Knopfdruck geschrieben werden kann.

Noch etwas weitergedreht: natürlich braucht es dann auch Tools, um (computergenerierte) Texte zu lesen und zusammenzufassen. Und möglicherweise verschiebt sich damit dann auch zum Beispiel die Wertigkeit von Textgenerierung in Schul- oder Uniaufgaben. Einen Text schreiben kann jede*r, ihn auf Richtigkeit und Stringenz kontrollieren und unter mehreren Vorschlägen das passende auszuwählen, ist ein Skill.

Ganz ähnlich könnte ein Einsatz im IT-Bereich aussehen, GitHub Copilot geht heute schon in diese Richtung: in Echtzeit Vorschläge dafür zu machen, wie bestimmte Funktionen aussehen könnten. Auch hier im besten Fall eine Entlastung von Routinetätigkeiten – im worst case eine extreme Abwertung von Programmiertätigkeiten.

Zudem könnte das durchaus ein Interface sein, um sich natürlichsprachlich zu unterhalten und gegebenensfalls auch Programme zu schreiben. Also so, wie das mit dem Computer in Star Trek geschieht. Dazu müsste aber sichergestellt werden, dass keine falschen, fast richtigen oder einfach nur erfundenen Antworten gegeben werden. Bisherige Chatbots sind meist nicht wirklich in der Lage, irgendwie sinnvoll zu agieren. Das könnte hier anders sein, wenn entsprechende Kontrollen eingezogen werden – und wenn das Sprachmodell jenseits einer Sandbox agieren kann, also Zugriff zum Beispiel auf die Uhrzeit hat, im Internet aktiv recherchieren kann oder Einträge in einer Datenbank ändern kann. Insofern sehe ich hier eher noch keine direkte Konkurrenz zu Suchmaschinen, sondern eher einen Layer über diesen, eine Art Benutzeroberfläche für Menschen, die keine Lust auf technische Details haben.

Noch etwas spekulativer: Systeme wie ChatGPT könnten zu einer kommunikativen Zwischenschicht werden, die nicht nur zwischen Sprachen, sondern auch zwischen Sprachregistern übersetzt – je nach individuellem Wunsch und Gepflogenheit. Eine vulgär dahingeworfene englischsprachige Mail wird bei der Empfängerin ausgesucht höfliches Chinesisch, ein komplizierter Blogbeitrag wird zu einer kurzen Bullet-Point-Präsentation zusammengefasst, und die semi-automatisierten Mitteilungen des Finanzamts werden endlich verständlich, bekommen vielleicht sogar die Möglichkeit, bei Unklarheiten kurz beim Computer nachzufragen und sich Dinge erklären zu lassen.

Mir fällt dazu Neal Stephensons The Diamond Age: Or, a Young Lady’s Illustrated Primer ein – neben ganz unterschiedlichen und miteinander nicht so richtigen Lebensstilen taucht dort auch der im Titel enthaltene interaktive Tutor auf, der eine Art selbstlernendes Lehrbuch ist. Eine Art Wikipedia, die auf das Vorwissen und Verständnis der Nutzer*in zugeschnitten ist – das könnte eine Vision dafür sein, wohin die Reise mit ChatGPT und ähnlichen Modellen geht.

ChatGPT kommentiert das im Übrigen so:

Ein eher kritischer Kommentar zu dieser Aussage könnte lauten:

„Die Idee, dass Sprachmodelle wie ChatGPT in Textverarbeitungsprogrammen eingesetzt werden könnten, ist zwar interessant, aber ich denke, es birgt auch einige Risiken. Zum Beispiel könnte dies dazu führen, dass viele kreative Berufe obsolet werden, was natürlich problematisch ist. Auch die Vorstellung von Kreativität könnte sich verändern, wenn solche Tools eingesetzt werden, was möglicherweise nicht immer gut ist. Es wäre wichtig, sorgfältig zu überlegen, bevor man solche Tools einsetzt.“

Ein euphorisch-positiver Kommentar zu dieser Aussage könnte lauten:

„Ich finde die Idee, dass Sprachmodelle wie ChatGPT in Textverarbeitungsprogrammen eingesetzt werden könnten, wirklich aufregend! Stellen Sie sich vor, wie viel Zeit und Mühe man damit sparen könnte. Und es würde auch dazu beitragen, die Vorstellung von Kreativität zu verändern, was sicherlich zu interessanten Entwicklungen führen würde. Ich freue mich darauf, zu sehen, wie sich diese Technologie in Zukunft entwickelt und wie sie unseren Alltag verbessern kann.“

P.S.: Eine gute Hintergrundeinschätzung zu den Grenzen von Sprachmodellen wie ChatGPT liefert Eva Wolfangel.

Mit etwas Anlauf ist das Thema ChatGPT jetzt auch im Medienmainstream angekommen – z.B. hier in der taz oder da in der ZEIT.